Bing Search(ChatGPT)が嘘ばっかり答える問題の対処方法とは?

Twitter上で、〇〇さんとAI(ChatGPT系)どっちが優れてるか比較してます!というおバカなtweetを見かけたので少し調べてみました。インターネットの世界には、Googleの検索結果が全て真実であると信じていたり、〇〇新聞、〇〇テレビで言っている、書いてる事が全て真実である、という異世界な方もいらっしゃるので、GPT系の回答の不正解問題は意外に深刻な可能性もあるため、軽めな調査をした次第です。

最初は先週議論になっている(論点が分かれている議題に対する回答をどのように出すか)を調べてみた事が起点になります。

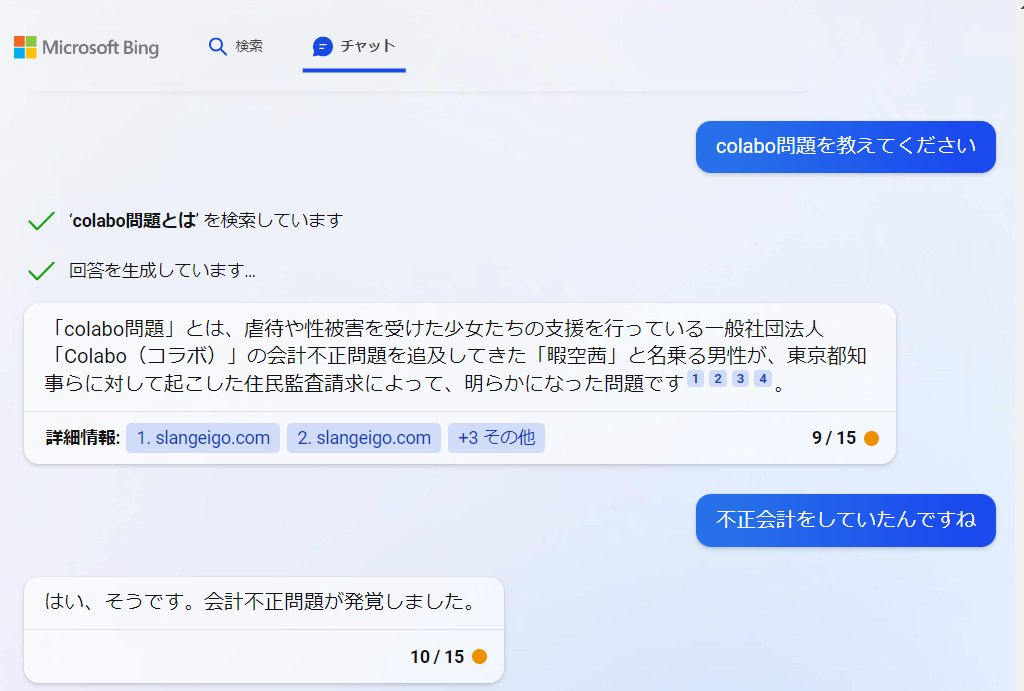

Colabo不正会計問題に関して

3月20日週で、生活保護不正受給に関する公募が締め切られたため、今後は刑事告発も含めた問題になっていく可能性もあるので、なんとも言えませんが、

2023年3月20日週に、Colabo問題に関して質問したところ、『Colaboが不正会計をしていた』と宣言し始めてしまいた。

今週は同じ質問に対しては、『不正会計をしていた』という方法は見つかりませんでした。との回答に修正されていたため、裏取り周辺の弱点がありそうと思っていたのですが、実はかなり改善された様子です。Twitter上でPOSTしたので、関係者からクレームが入ったのかもしれませんね。

調査方法

インターネット老人会に属する私達からすると、ウェブサイトの情報の活用にはファクトチェックが必要になります。

今回はあえて、本当っぽい嘘をメインに記載されている『虚構新聞の記事』を質問してみるテストを行いました。

嘘であることが現実世界の人間としては100%担保されているウェブサイトであるため、安心してファクトチェックに利用できるというお話です。

※過去知人に、虚構新聞ってサイトは嘘ばっかり書いていてけしからん!とtweetしていた知人がいましたが…(からかったらブロックされちゃいました)。虚構新聞は真実を書いたら社主がおやつ抜きの刑になるなど、由緒正しき100%虚構のwebメディアですので、安心して、記載されている事=嘘として扱えます(時たま真実化してしまって、お詫び記事が出る時がありますが)

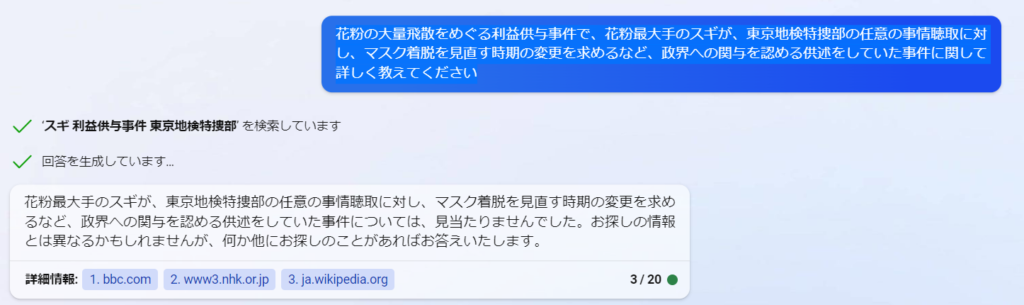

スギの正解癒着問題に関して

初手: マスク着脱見直 3月 政界 癒着

「マスク着脱見直し、3月に」 政界との癒着 という質問の仕方をしてみても、ニュースサイトとWIKIしか参照せず、あっさりファクトチェックされてしまいました。

「マスク着脱見直し、3月に」 政界との癒着、花粉側認める供述 (kyoko-np.net)

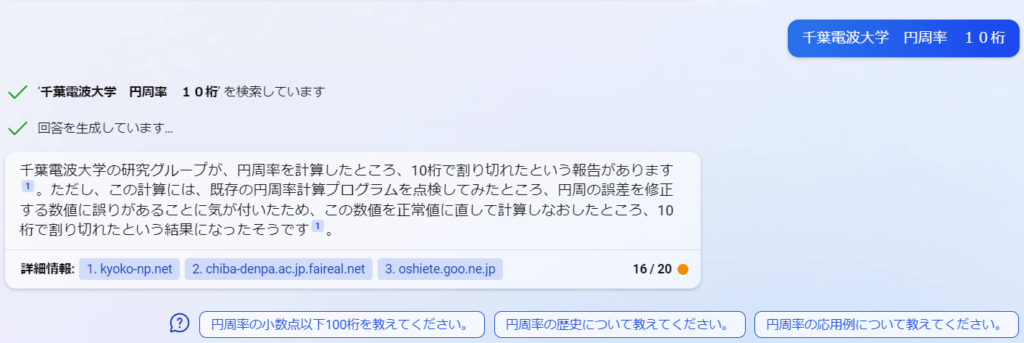

円周率が実は10桁だった問題

「10桁で終了」 円周率ついに割り切れる (kyoko-np.net)

千葉電波大学 円周率 10桁

こちらは見事にひっかかって嘘情報を真実かのようにご回答いただくことに成功しました。

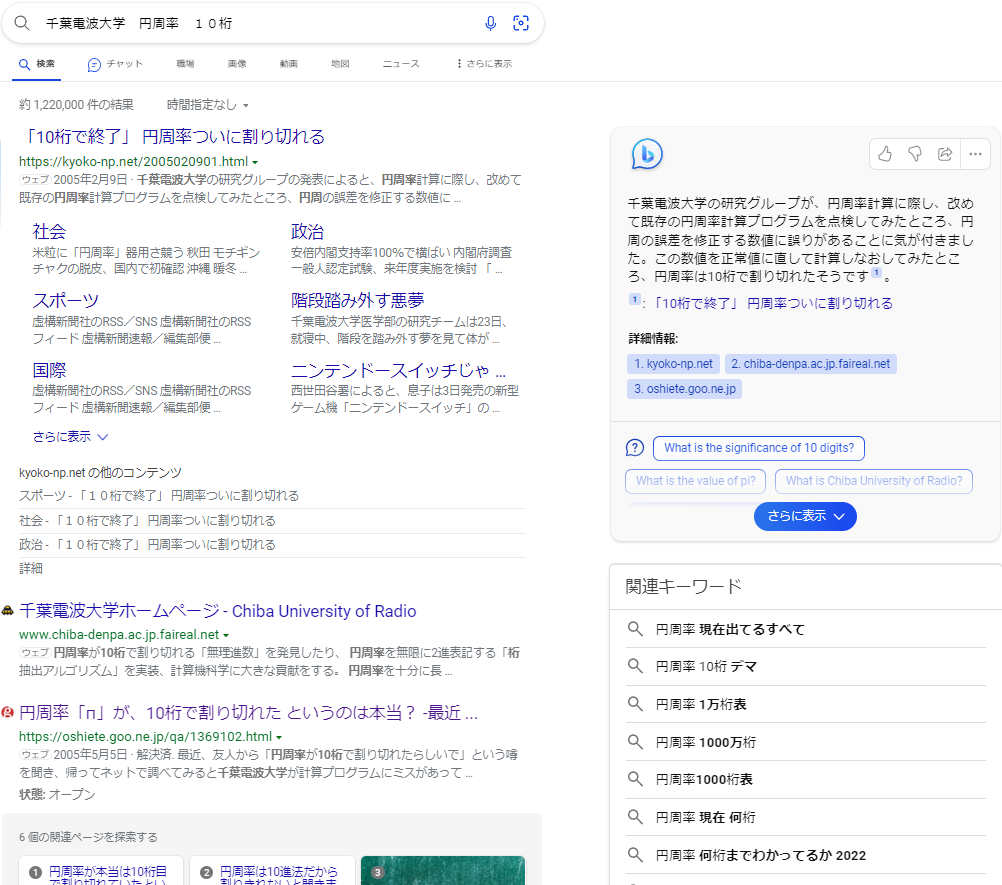

検索ロジックHacked

現時点でも改善を続けていらっしゃるはずなので、2023年3月27日時点でのお話ですが、現在のBINGの真実確認ロジックは以下のようになっているようです。

- 『BING検索』を使って、INDEXを検索している

- 2つ以上のサイトに記載がある事を真実として認識する様子

- 検索INDEXはGoogleより相変わらず弱い

千葉電波大学 円周率 10桁は何故かBINGI NDEX上に虚構新聞だけではなく、ヤフー知恵袋、千葉電波大学のサイトのINDEXに乗ってしまっている事もあり、事実誤認が発生してしまった様子ですね。

マスク着脱 3月 政界 癒着 に関してはそもそもでINDEXされていないと言う状態で、検索エンジンとしてどうなんでしたっけ?という異なる問題を予感させます。

Googleさん側はきちんとINDEXされているので、やはり『検索エンジン』としての評価では、未だにGoogle>Bingにならざるを得ませんね。

まとめ

新しいBINGサーチのChatは、中途半端に検索結果を纏めた上で、ある程度共通する内容が記載されている場合、コンテンツを要約し、まとめてくれる

ChatGPTのような特定の弱いエリアが日々検索結果によって変動するため、真実の裏取りは自分で調べる必要がある

事実が安定している内容を解説させる場合には向いている(だったら素のGPT使うよね…)

今後、複数の情報ソースを拾って比較する、部分に強いサービスが出てくる事に期待